ここ数ヶ月の間、人工知能のコミュニティは、アップル社が発表した2つの影響力のある研究論文に端を発した激しい議論に包まれている。1つ目は、"illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic"(2024年10月)、そして2つ目は、 "思考の幻想"(2025年6月)は、ラージ・ランゲージ・モデルの推論能力に疑問を投げかけ、業界全体にさまざまな反応を引き起こした。

以前の詳細な分析で既に検討したように 「進歩という幻想:人工知能の実現に至らない人工知能のシミュレーション」で分析したように、人工推論の問題は、機械の知能とは何かという核心に触れるものです。

アップルの研究者たちは、大規模推論モデル(Large Reasoning Models:LRM)、つまり答えを出す前に詳細な推論トレースを生成するモデルについて体系的な分析を行った。その結果は驚くべきものであり、多くの人にとって憂慮すべきものであった。

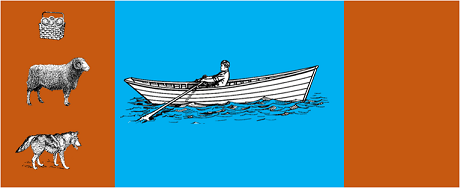

この研究では、最先端のモデルを次のような古典的なアルゴリズムパズルにかけた:

その結果、問題の定式化を少し変えただけでも成績に大きなばらつきが生じることがわかり、推論のもろさが心配される。AppleInsiderの アップルインサイダーGSM-Symbolicベンチマーク問題の数値のみを変更した場合、すべてのモデルのパフォーマンスが低下する」。

AIコミュニティからの反論はすぐに届いた。オープン・フィランソロピーのアレックス・ローセンは、アンソロピックのクロード・オーパスと共同で、次のようなタイトルの詳細な反論を発表した。 考えるという幻想』。アップル社の研究の方法論と結論に異議を唱えている。

ローゼンが別の方法論(すべての手をリストアップするのではなく、モデルに再帰関数を生成するよう求める)でテストを繰り返したところ、結果は劇的に異なった。クロード、ジェミニ、GPTなどのモデルは、15レコードのハノイの塔の問題を正確に解いた。

ゲイリー・マーカス長年にわたってLLMの推論能力を批判してきたマーカスは、今回のアップル社の調査結果を、自身の20年にわたる論文を裏付けるものとして受け止めた。マーカスによれば、LLMは「すでに解決された問題を解くのが得意」である一方で、「分布の変化」(訓練データを超えて一般化する能力)に苦戦し続けているという。

この議論は、次のような専門コミュニティにも広がっている。 RedditのLocalLlamaなどの専門コミュニティにも広がっており、開発者や研究者がオープンソースモデルやローカル実装の実際的な意味について議論している。

この議論は純粋に学術的なものではない。直接的な意味合いを持つ:

いくつかの 技術的洞察を組み合わせたハイブリッド・アプローチの必要性が高まっている:

些細な例だが、AIアシスタントが記帳をサポートする。言語モデルは、あなたが "今月は旅行にいくら使いましたか?"と尋ねると理解し、関連するパラメータ(カテゴリー:旅行、期間:今月)を抽出する。しかし、データベースに問い合わせ、合計を計算し、財政制約をチェックするSQLクエリは?それはニューラル・モデルではなく、決定論的コードによって行われます。

アップルの論文がWWDCの直前に発表され、戦略的な動機について疑問が投げかけられていることは、オブザーバーにとって見逃せない事実だった。9to5Macによる9to5Macによる分析WWDCの直前というAppleの論文のタイミングは、いくつかの眉をひそめた。これは研究のマイルストーンなのか、それとも広いAI展望の中でアップルを再配置する戦略的な動きなのか?"

アップルの論文に端を発した議論は、私たちがまだ人工知能を理解する初期段階にいることを思い起こさせる。前回の 前回の記事シミュレーションと本物の推論を区別することは、現代における最も複雑な課題のひとつである。

真の教訓は、LLMが人間的な意味での「理性」を発揮できるかどうかではなく、その限界を補いつつ長所を活かすシステムをいかに構築できるかということだ。AIがすでに全分野を変革しつつある世界では、もはやこれらのツールが「賢い」かどうかではなく、いかに効果的かつ責任ある使い方をするかが問われている。

エンタープライズAIの未来は、おそらく単一の画期的なアプローチにあるのではなく、いくつかの補完的なテクノロジーをインテリジェントにオーケストレーションすることにある。そして、このシナリオでは、ツールの能力を批判的かつ正直に評価する能力そのものが競争上の優位性となる。

最新動向(2026年1月)

OpenAI、o3およびo4-miniをリリース:2025年4月16日、OpenAIはoシリーズで最も先進的な推論モデルであるo3およびo4-miniを一般公開しました。これらのモデルは、ウェブ検索、ファイル分析、視覚的推論、画像生成を組み合わせて、エージェント的にツールを使用できるようになりました。 o3はCodeforces、SWE-bench、MMMUなどのベンチマークで新記録を樹立し、o4-miniは大量の推論タスクにおけるパフォーマンスとコストを最適化します。これらのモデルは「画像による思考」能力を発揮し、より詳細な分析のためにコンテンツを視覚的に変換します。

DeepSeek-R1がAI業界に衝撃を与える:2025年1月、DeepSeekはR1をリリースしました。これはオープンソースの推論モデルであり、わずか600万ドル(欧米のモデルが数億ドルかかるのに対し)のトレーニングコストでOpenAI o1に匹敵する性能を達成しました。 DeepSeek-R1は、人間の注釈付きデモンストレーションを必要とせずに、純粋な強化学習によって推論能力を向上させることができることを実証しています。このモデルは、数十カ国のApp StoreおよびGoogle Playで無料アプリランキング1位を獲得しました。 2026年1月、DeepSeekは60ページにわたる詳細な論文を発表し、トレーニングの秘訣を明らかにするとともに、モンテカルロツリー探索(MCTS)などの手法は一般的な推論には効果がないことを率直に認めています。

Anthropic、Claudeの「憲法」を更新:2026年1月22日、AnthropicはClaudeの新しい23,000語の憲法を発表し、ルールベースのアプローチから倫理原則の理解に基づくアプローチへと移行しました。 この文書は、AIの意識や道徳的地位の可能性を正式に認めた大手AI企業初の枠組みとなり、Anthropicがクロードの「心理的幸福、自己認識、幸福」を重視していることを表明しています。

議論が激化:2025年7月の研究では、Appleのベンチマークを再現・改良し、複雑さが中程度に増す(ハノイの塔で約8枚の円盤)と、LRMは依然として認知的限界を示すことを確認しました。研究者らは、これは出力の制約だけでなく、実際の認知的限界にも起因することを実証し、議論がまだ決着していないことを強調しました。

お客様の組織のAI戦略に関する洞察や、堅牢なソリューションの導入については、当社の専門家チームがカスタマイズしたコンサルティングを提供します。